欢迎查看以太网是什么文章,小旻尽量解答大家对INFINIBAND和以太网的永恒之战的疑问

以太网是什么

在优化系统的时候,有选择总是好的,因为并非所有软件的行为方式都相同,而且并非所有机构都有相同的预算来尝试在 他们的HPC 集群上运行其的模拟和模型。出于这个原因,随着时间的推移,我们看到了 HPC 系统中使用各种互连和协议,我们认为多样性不会减少。如果有的话,随着摩尔定律的终结,它可能会增加。

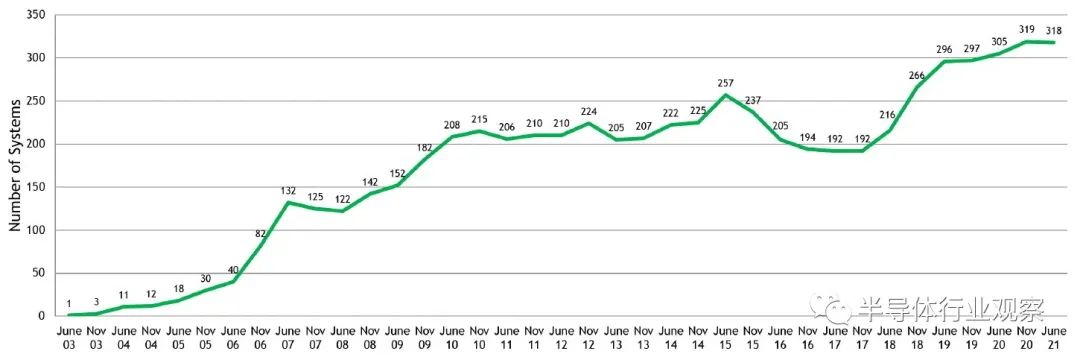

在一年两次的超级计算机 Top500 排名中,我们深入了解可互连趋势,并发现结果总是很有趣的。在最近的 ISC 2021 超级计算大会上,最新的Top500 名单备用不,我们分析了名单上的新系统以及排名中体现的所有计算指标,现在是时候看看互连了。G

ilad Shainer 是 Nvidia(前身为 Mellanox Technology)营销高级副总裁并管理 Quantum InfiniBand 交换机产品线,他总是对 Top500 互连进行分析,并始终与我们分享。现在,我们可以与您分享它——我们的分析是最重要的,我们牢不可破的习惯也是如此。让我们开始。

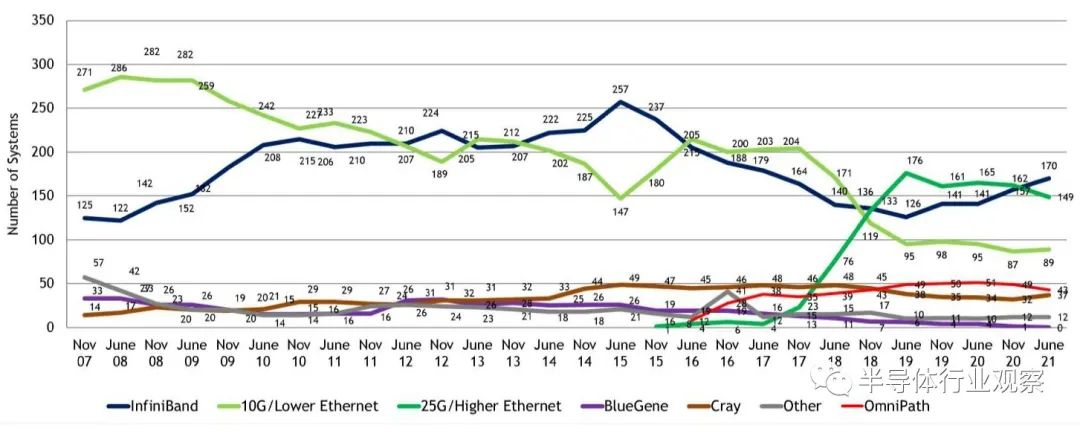

如下图所示,我们看一下2007 年 11 月至 2021 年 6 月之间 Top500 列表中互连的历史趋势:

我们和 Shainer 一样清楚地意识到,Top500 名单包括学术、政府和行业 HPC 系统以及由服务提供商、云构建者和超大规模者构建的系统,因此这绝不是纯粹的“超级计算机”列表,因为人们通常将运行传统模拟和建模工作负载的机器称为机器。

很明显,InfiniBand 会随着时间的推移而起伏不定,在此图表所示的 13 年半中,10 Gb/秒和较慢的以太网在较小程度上一直在减弱。InfiniBand 正在崛起,其 Omni-Path 变体(由英特尔控制,现在由 Cornelius Networks 所有)一直保持稳定,直到 2021 年 6 月的名单有所下滑。以 25 Gb/秒或更高速度运行的以太网一直在上升,但是,在 2017 年至 2019 年间增长更快,当时 100 Gb/秒交换(通常是 Mellanox Spectrum-2 交换机)比前几代 100 Gb/sec 技术更快,它依赖于更昂贵的传输,因此大多数 HPC 不会考虑。

无论如何,如果将 Nvidia InfiniBand 和 Intel Omni-Path 加在一起,以公平计算 InfiniBand 在 2021 年 6 月的排名中的代表,那么有 207 台机器,占列表的 41.4%。我对列表中的其他一些所谓的“专有”互连表示怀疑(主要是中国的机器),我们也认为其是 InfiniBand 变体。

在以太网方面,在过去四年中,以太网在 Top500 中的互连份额从 2021 年 6 月列表中的 248 个低到 2019 年 6 月列表中的 271 个高位。近年来,InfiniBand 一直在切入以太网,考虑到 HPC(以及现在的 AI)工作负载的延迟敏感性以及随着 InfiniBand 容量的增加,InfiniBand 的成本会随着时间的推移而降低,这对我们来说并不奇怪。

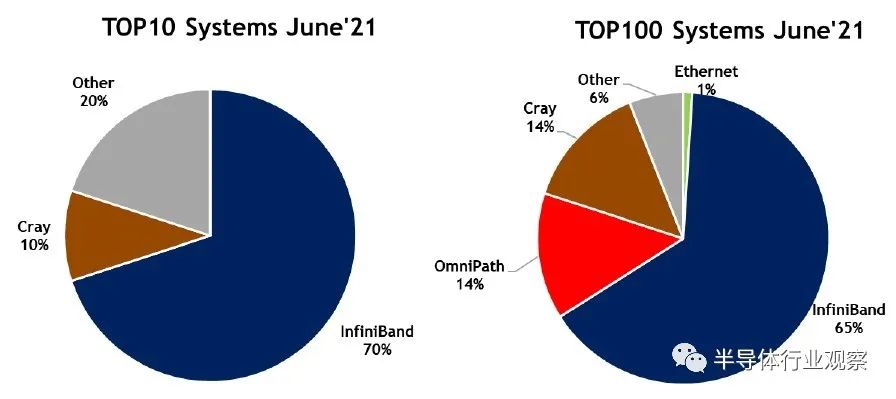

大多数 Top100 系统和列表中的所有 Top10 系统都是我们所说的真正的超级计算机——这意味着它们将传统的 HPC 作为日常工作,尽管越来越多的机器在兼职做一些 AI。她是这些上层机器的互连分布情况:

正如你可以看到,以太网在这里并没有太出色的表现,但一旦惠普始出货200 Gb/sec的Slingshot——由Cray开发的以以太网的HPC-扭捏变种,并在今年晚些时候把系统提供给“前沿”百亿亿级机器,且进入橡树岭国家实验室之后,情况将发生变化。

但Shainer 和 Top500 子列表生成器都没有将 Slingshot 称为以太网的变体,事实上,劳伦斯伯克利国家实验室的“Perlmutter”系统在性能排名中排名第五,使用的是 Slingshot-10 变体,它是每个节点上有两个 100 Gb/秒端口。

InfiniBand 可能会拥有更大的影响力。榜单上的顶级机器,日本 RIKEN 实验室的“Fugaku”系统,使用了富士通开发的第三代 Tofu D 互连,该互连实现了自主研发的 6D 环面融合拓扑和专有协议。

在 Top100 中,Cray 互连不仅包括第一台 Slingshot 机器,还包括一堆使用上一代“Aries”互连的机器。2021 年 6 月的 Top100 榜单中有 5 台 Slingshot 机和 9 台 Aries 机。如果你称之为 Slingshot Ethernet,那么 Ethernet 拥有 6% 的份额,而专有的 Cray 则下降到 9%;如果你将 Mellanox/Nvidia InfiniBand 添加到 Intel Omni-Path,InfiniBand 在 Top100 中有 79 台机器。

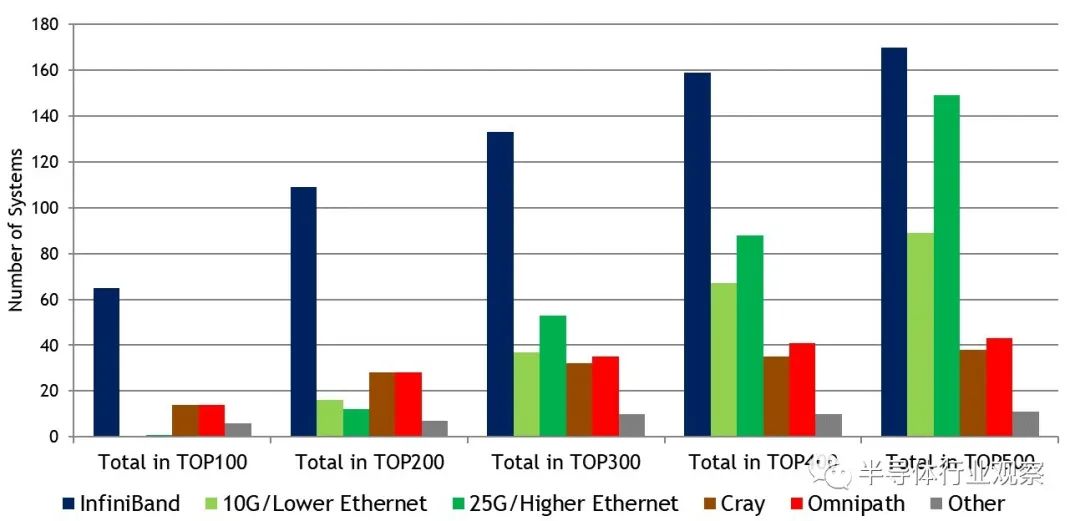

以下是当您以 100 台机器为增量将孔径从 Top100 扩大到 Top500 时互连的分布情况:

正如您可能预期的那样,随着列表的散开,以太网的渗透率不断上升,许多学术和工业 HPC 系统无法负担 InfiniBand 或不愿意放弃以太网。作为这些服务提供商、云构建者和超大规模者,出于任何政治或商业原因,他们在集群的一小部分上运行 Linpack。相对较慢的以太网在 Top500 列表的下半部分很受欢迎,而 InfiniBand 在那里下降,其渗透率从 Top10 中的 70% 下降到整个 Top500 中的 34%。

这是另一个有趣的图表,它汇集了 Top500 名单上的大部分 InfiniBand 和许多以太网,它部分解释了为什么 Nvidia 斥资 69 亿美元收购 Mellanox:

英伟达的 InfiniBand 在 Top500 互连中占有 34% 的份额,有 170 个系统,但并不明显的是 Top500 上的 Mellanox Spectrum 和 Spectrum-2 以太网交换机的崛起,它们增加了 148 个系统。这使英伟达在 Top500 排名中的所有互连中占有 63.6% 的份额。这就是思科系统公司过去 20 年在企业数据中心享有的那种市场份额,这是一项了不起的成就。

Nvidia 不必关心您购买哪种网络——它最关心的是您从哪个供应商处购买。这是一个真正的竞争优势,其代价是拥有两条不同的开关线路。那场战斗是为英伟达设计的。

★ 点击文末【阅读原文】,可查看本文原文链接!

*免责声明:本文由作者原创。文章内容系作者个人观点,半导体行业观察转载仅为了传达一种不同的观点,不代表半导体行业观察对该观点赞同或支持,如果有任何异议,欢迎联系半导体行业观察。